SEO kursa pirmajā rakstā iepazināmies ar to, kā strādā Google meklētājs, kā tas atrod mājaslapas, tās sadaļas, kā tās tiek indeksētas un pēc tam attēlotas arī Google meklētājā. Minējām arī Google pārmeklēšanu jebk Crawling, ko paveic Google bots jeb speciāla programmatūra. Apskatījām arī dažus pamatvirzienus, faktorus, kam būtu jāpievērš uzmanība, lai uzlabotu mājaslapas draudzīgumu Google botam. Šajā rakstā apskatīsim detalizētāk vairākus faktorus, pie kā jāpiestrādā, lai vēl vairāk iepatiktos Google meklētājam un SEO optimizācijas process jau saknē būtu vienkāršāks.

Meta tegi un Robots.txt fails

Ne reizi vien ir gadījies sastapties ar situāciju, kad mājaslapas veidotāji paši ir lieguši Google meklētājprogrammai piekļūt mājaslapai, tāpēc, ja rodas aizdomas, ka mājaslapa netiek indeksēta meklētājā vispār vai tas notiek tikai daļēji, ir vērts sākumā pārbaudīt Meta tegus un Robots.txt failu. Ir vairākas komandas, kas var Meta tegos un Robots.txt failā liegt piekļūt mājaslapai vai tās sadaļām, tāpēc apskatīsim tos.

Mājaslapas izslēgšana no indeksācijas ar robots meta tegu

Ja Jums mājaslapā ir sekojošs tegs, tad nav nekādu iespēju, ka jebkādi roboti, ieskaitot Google botu spēs piekļūt Jūsu lapai un indeksēt tās saturu, tā ir komanda, kas gluži vienkārši jau sākumstadijā to liedz:

<meta name="robots" content="noindex" />Nofollow saites

Ja saitēm mājaslapā ir pievienots zemāk redzamais tegs, Google bots redzēs saiti, bet nesekos tai, jo tāda komanda ir dota (“nofollow” no agļu valodas – “nesekot”).

Ir divu veidu nofollow komandas, visam mājaslapas saturam:

<meta name="robots" content="nofollow">un konkrētai saitei:

href="pagename.html" rel="nofollow"/>Var gadīties, ka šīs komandas ir jāizmanto, visbiežāk mājaslapu īpašnieki otro komandu izmanto tām no mājaslapām izejošās saitēm, pa kurām nav vēlmes nodot autoritāti lapām, uz kurām tiek veidota saite (vai nu lai pasargātu savas mājaslapas SEO spēku)

Mājaslapas bloķēšana ar Robots.txt faila palīdzību

Robots.txt fails ir pirmais, uz ko skatās roboti, kad piekļūst mājaslapai, tāpēc, ja tur uzreiz ir norādīti konkrēti liegumi robotiem, tie to ievēros un mājaslapu var neskatīt vai neindeksēt:

User-agent: *

Disallow: /Šī komanda nozīmē, ka visiem robotiem (apzīmē ar *) tiek liegta piekļuve mājaslapas saturam, viss, kas ir aiz /, domēna galvenās lapas (Disallow: /)

User-agent: *

Disallow: /produkti/Šajā gadījumā tiks bloķētas visas lapas, kas atrodas mapē /produkti/. Šo paņēmienu bieži vien izmanto, lai no meklētājiem noslēptu tādu saturu, kuru nav vēlmes izplatīt publiski, ko var atrast tikai ar speciālām saitēm (lietotāju profili, cita sensitīva informācija u.c.)

Iekšējo saišu problēmas

Ja iekšējās saites nedarbojas, tā jebkurā gadījumā ir problēma – vai nu jābūt pāradresācijai uz strādājošu lapu vai tāda saite ir jānoņem. Nestrādājošas saites traucē gan mājaslapas apmeklētājiem, gan arī ļoti nepatīk Google botam. Vēl viens arguments – Google botam ir ierobežots laiks katrai mājaslapai un ja tam jāpavada daļa laika, pārbaudot nestrādājošas saites, tad tiek lieki iztērēts laiks.

URL kļūdas

Bieži vien tās rodas, nepareizi ievadot URL adresi, noraujot kādu daļu, kopējot pazaudējot un citādi. Tāpēc vienmēr ir ieteicams pēc saites izveides pārbaudīt to, pašam uzklikšķinot uz jaunizveidotās saites.

Novecojuši URL

Ja saites tiek veidotas uz citām lapām, to saturs visbiežāk netiek kontrolēts, tāpēc to sadaļas var tikt mainītas, dzēstas, labotas, var tikt mainītas URL adreses. Visu šo gadījumu rezultātā var izveidoties situācija, ka saite mājaslapā nedarbojas, ja vien otras lapas īpašnieks nav izveidojis pāradresāciju. Vēlams ar SEO rīku palīdzību veikt regulāru saišu monitoringu, kas uzrādīs problēmas ar saitēm, ja tādas pēkšņi rastos.

Lapas ar ierobežotu piekļuvi

Var gadīties, ka saite atgriež 403 kļūdas rezultātu, kas nozīmē, ka lapa var būt ierobežota, piemēram, tikai reģistrētiem lietotājiem. Šīs saites labāk pārveidot par nofollow saitēm, lai netērētu liekus robotu resursus.

Ar serveri saistītas problēmas

Servera kļūdas

5xx sērijas kļūdas (piemēram, 503 kļūda) var liecināt par servera problēmām, kad mājaslapa vai sadaļa lēni ielādējas vai neielādējas vispār. Tādā gadījumā atliek lūgt web izstrādes (vai servera) kompāniju palīdzību, lai atrisina ar serveri radušās problēmas. Tās var būt gan mājaslapas tehniskas problēmas, gan servera uzstādījumu problēmas, uzbrukumi mājaslapai.

Ierobežota servera kapacitāte

Iespējams, ka brīdī, kad tika veidota mājaslapas, servera kapacitāte ļāva to lietot pilnā apjomā bez problēmām, bet laikam ejot, mājaslapa piepildījusies ar jaunu saturu, attēliem, failiem, kas piepildījusi mājaslapas servera kapacitāti. Tādos gadījumos jāveic servera pārkonfigurācija, jāpāriet uz lielāku maksājumu plānu vai jāmaina serveris pavisam. Arī te palīdzību sniegs servera serviss vai web izstrādes kompānija, kas atbild par mājaslapas uzturēšanu.

Web servera nepareizi uzstādījumi

Šis var būt arī sarežģītāks jautājums. Mājaslapa var būt lieliski redzama apmeklētājiem, bet tā izmet kļūdas robotiem, tādējādi visas sadaļas var kļūt nepieejamas pārmeklēšanai. Tas var notikt dažādu servera konfigurāciju dēļ: dažādi ugunsmūri (piemēram, Apache mod_security) pēc noklusējuma var bloķēt Google botu un citus meklēšanas botus. Īsāk sakot, šī problēma ar visiem saistītajiem aspektiem ir jārisina web izstrādes speciālistam.

Lapas kartes problēmas

Formatēšanas kļūdas

Pastāv vairāki formatēšanas kļūdu veidi, piemēram, nederīgs URL vai trūkstoši tegi (meklējiet visu sarakstu ar katras kļūdas risinājumu šeit).

Iespējams, esat arī sapratis (pie pirmās darbības), ka vietnes kartes failu bloķē robots.txt. Tas nozīmē, ka boti nevar piekļūt mājaslapas kartes saturam.

Nepreizas sadaļas lapas kartē

Nav jābūt web izstrādes speciālistam, lai pārbaudītu, cik korekta ir lapas karte (sitemap). Pārbaudiet, vai visas sadaļas tajā ir korektas, vai visi URL attainoti pareizi, vai ir jaunais saturs redzams, viss, ko vēlaties, lai meklētājs atrod. Bieži vien lapas kartes kļūdas izmet pati Google Search Console bezmaksas platformā, tāpēc ik pa laikam ir jāieskatās arī tur, vai nav kādas kļūdas.

Mājaslapas arhitektūras kļūdas

Šī ir vissarežģītākā sadaļa, ko risināt, tāpēc pie tās jāķeras tad, kad viss iepriekš minētais ir pārbaudīts uz izlabots.

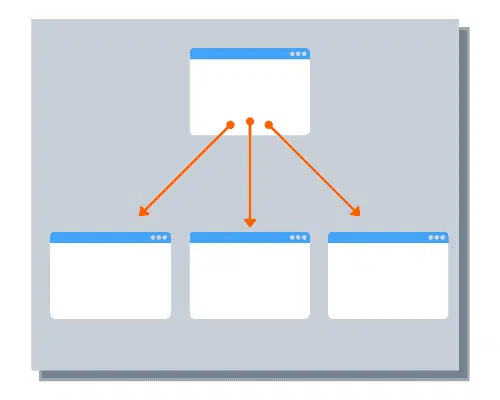

Iekšējo saišu problēmas

Dažādas sekojošas problēmas var tikt konstatētas ar dažādu SEO rīku palīdzību:

- sadaļa nav savienota ne ar vienu citu mājaslapas sadaļu, tāpēc arī neparādas indeksā

- sadaļa atrodas pārāk tālu no galvenās lapas, tāpēc Google bots līdz tai nenokļūst. Ieteicams ir ne vairāk kā 4 līmeņu saites (piemēram, 4 līmeņu apakškategorijas)

- pārāk daudz izejošo saišu sadaļā. Ja vienā lapā ir vairāki tūkstoši izejošo saišu, Google botam var rasties problēmas ar to visu nolasīšanu

- saites ir paslēptas zem dažādiem risinājumiem – Java, Flash, tāpēc tās netiek nolasītas

Nepareizas pāradresācijas

Pāradresācijas kopumā ir vērtīgas, jo tad var no vienas mājaslapas sadaļas pārsūtīt apmeklētāju uz citu sadaļu. Sevišķi svarīgi tas ir gadījumos, kad saite uz sadaļu ir izvietota dažādos ārējos resursos un to izmainīt vairs nav iespēju. Attiecīgi, izveidojot pāradresāciju, lietotājs nemanāmi tiek pārvietots uz citu sadaļu, aktuālo.

Taču dažreiz pāradresācijas var nodarīt ļaunu mājaslapas SEO optimizācijai:

- 302 vai 307 pāradresācijas liek Google robotam konkrēto lapu apmeklēt vēl un vēl, tas patērē resursus, tāpēc, ja ir skaidrs, ka esošā lapa tiek pāradresēta uz visiem laikiem, tad jāizmanto 301 pāradresācija, kas pasaka robotam, ka tā ir galēja pāradresācija un veco lapu vairs nav jāapmeklē. Minētās 302 vai 307 pāradresācijas var izmantot, ja pāradresācija ir uz laiku

- pāradresāciju loks jeb redirect loop ir tad, kad viena lapa pāradresē uz citu un tā atkal atpakaļ, sanāk bezgalīga pāradresācija, kas nekad nebeidzas un lieki tērē robotu resursus. Diemžēl šādi loopi ir visai bieža parādība.

Lēns ielādes ātrums

Kā jau minēts iepriekš, mājaslapas un tās sadaļu ielādes ātrums tiešā mērā var noteikt to indeksācijas veiksmi. Mājaslapām un sadaļām jāielādējas ātri un to var pārbaudīt ar Google Page Speed rīku. Problēmas var būt daudz un dažādas – attēlu optimizācija, pārāk smags lapas kods, neoptimizēts dizains utt. Visticamāk paša spēkiem tikt galā ar to būs grūti, tāpēc jāsauc palīgā web izstrādes speciālists. Diemžēl daudzi web izstādes kantori piedāvā jau pamatā vāji optimizētas mājaslapas, uzmanīgi jāizvēlas savas mājaslapas attīstītājs un uzturētājs, jāmeklē atsauksmes, jājautā darbu portfolio un jāpārbauda izstrādātās lapas uz ātrumu.

Dubultais saturs

Bieži vien indeksācijas problēmas rodas dēļ dubultā satura. Mājaslapā ir vairākas sadaļas par vienu un to pašu tēmu, Google robots uzskata, ka par konkrēto tēmu jau ir viena lapa un īsto var neindeksēt vai indeksēt zemāk. Tāpēc uzmanīgi jāseko līdzi saturam mājaslapā. E-komercijas projektiem bieži šāda veida problēmas rodas dēļ tehniskiem risinājumiem – vairākas lapas produktu kategorijā (1, 2, 3, 4… 154 – pagination). Produktu lapas var tikt attēlotas ar dažādiem meklēšanas filtriem – lapa tā pati, bet URL jau cits, kas Google acīs būs dubultais saturs.

Lai no tā izvairītos:

- jādzēš dubultās lapas – atkārtoti bloga raksti, jaunumi, nejauši duplicētas lapas

- jāveic uzstādījumi robots.txt failā, lai netiktu indeksēts dubultais saturs

- meta tegu uzstādījumi, kas neindeksē dubulto saturu

- 301 pāradresācija

- rel=canonical tega izmantošana (tas pasaka robotam priekšā, ka šī lapa ir galvenās lapas kopija)

Javascript un CSS nepareiza izmantošana

Vēl tālajā 2015. gadā Google oficiāli apgalvoja: “Kamēr nebloķējat Google botu no JavaScript vai CSS failu pārmeklēšanas, mēs kopumā spējam atveidot un izprast jūsu mājaslapas tāpat kā galvenās pārlūkprogrammas.” Tas gan neattiecas uz citām meklētājprogrammām (Yahoo, Bing, Yandex u.c.). Turklāt vārds “kopumā” nozīmē, ka dažos gadījumos pareiza indeksācija netiek garantēta.

Vecas web dizaina tehnoloģijas

Flash saturs

Flash ir novecojusi tehnoloģija un tā netiek atbalstīta dažās mobilās ierīcēs. Saites, kas iekļautas Flash saturā, netiek pakļautas indeksācijai un saturs netiek nolasīts, attiecīgi negatīvi ietekmē SEO optimizācijas procesu.

HTML freimi

Ja mājaslapā ir tā saucamie freimi, tā reizē ir laba un slikta ziņa. Tas ir labi, jo tas, iespējams, nozīmē, ka jūsu mājaslapa ir pietiekami nopietna. Tas ir slikti, jo HTML freimi ir ārkārtīgi novecojuši, tiek slikti indeksēti, un jums tie ir pēc iespējas ātrāk jāaizstāj ar mūsdienīgāku risinājumu.

MMN vadītājs Aigars mārketingā pirmo pieredzi guvis mārketinga speciālista amatā veikalu tīklā Drogas 2005.gadā. Vēlāk pievērsies privātiem interneta projektiem. 2011.gadā pievienojies nepilnu gadu vecam uzņēmumam Infinitum 8, attīstot to līdz tobrīd Latvijas vadošai digitālā mārketinga aģentūrai, kas piedāvā Google produktus.